La théorie du climat existe-t-elle ?

L’esprit critique est à la base de la culture scientifique. Nous allons d’erreurs corrigées en erreurs corrigées, disait Bachelard. Popper, quant à lui, expliquait que la différence entre science et la religion, c’est la démarcation : le fait de pouvoir falsifier un modèle scientifique, là où la religion procède d’une foi initiale ou d’une révélation. Ici, je conteste le caractère doctrinaire des hypothèses et prévisions incertaines du GIEC. La démarche scientifique commençant dans la liberté de controverse, ouvrons le débat.

Le corolaire immédiat de la science, c'est qu'elle ne peut nous enseigner une vérité dogmatique à laquelle se soumettre. Aussi, ceux qui prêchent cette dénaturation de l’esprit scientifique s’appellent des scientistes.

Scientisme et idéologie scientifique

Ils font de la science une idéologie, pratiquent des extrapolations hasardeuses au nom de leur idéologie enrobée de savoirs scientifiques dénaturés et veulent faire taire leurs opposants, dominer les autres, exercer un pouvoir autoritaire, voire autocratique. Puisque la véritable démarche scientifique est faite de débats argumentés, étudions. Quand des institutions dissuadent de toute controverse scientifique, au prétexte que la vérité serait connue et définitive, c'est à ce moment qu'il convient d'exercer son esprit critique.

La complexité des facteurs d’une théorie du climat

Comme le climat est un sujet très complexe, deux aspects sont à considérer : la possibilité même de sa modélisation et la fiabilité des projections entre prévisions et prédictions.

Question 1 : les facteurs sont-ils connus ?

Il y a théorie scientifique sous réserve de disposer des notions, de leurs définitions, de leur unité de calcul et de l’instrument de mesure qui permet de donner une valeur à chacune de ces notions dans leur unité de calcul.

Exemple : la masse, grandeur positive et constante d’un corps qui rend compte de la quantité de matière dans une unité : gramme, kilogramme, tonne, mesurable de manière répétée, fiable et exacte par un instrument de pesée.

Pour construire une théorie, il faut disposer de plusieurs notions qui vont s’ordonner dans une équation. C’est le travail de modélisation qui rend compte d’une catégorie de phénomènes.

Exemple : V = gt. Cette équation calcule la vitesse en chute libre. V correspond à la vitesse de chute en mètres par seconde, deux unités parfaitement mesurables, g à l'accélération gravitationnelle en mètres par seconde au carré et t au temps de chute en seconde. À tout instant de la chute, la vitesse est connaissable avec exactitude. L’équation permet de prédire avec certitude ce qu’il en est de cette vitesse, dans le champ gravitationnel. La valeur de g, qui définit avec précision au fil du temps par accumulation des mesures expérimentales, est de : 9,806 65 m / s -2 . Cette valeur conventionnelle a été arrêtée lors de la troisième convention internationale des poids et mesures de 1901.

En matière climatique, la complexité tient à la multiplicité des facteurs qui interviennent dans la composition et l’évolution du climat. Citons, par exemple, les océans et les courants marins, les reliefs terrestres, les mouvements atmosphériques, les vents, anticyclones et dépressions, la position en termes de latitude dans les hémisphères et l’activité solaire. Chaque facteur renvoie à des domaines scientifiques complexes : astronomie, physique, géologie, chimie, etc. Et dans ces sciences, l’exhaustivité des facteurs n’est pas acquise.

Question 2 : ses facteurs sont-ils modélisables ?

Examinons successivement les courants marins et l’activité solaire.

Les courants marins

Le Gulf Stream est un courant d’eaux chaudes remontant des Caraïbes (Golfe du Mexique) le long des côtes européennes. Il contribue à un climat très tempéré pour les côtes exposées. À l’inverse, le courant du Labrador descend le long des côtes nord-américaines et impacte le climat froid. Ces courants marins exercent une influence sur les masses d’airs, dépressions montant vers l’ouest européen entraînant des pluies et anticyclones froids descendant sur l’Amérique du Nord. Cette description n’éclaire pas sur le modèle.

Savons-nous comment fonctionnent ces courants ? Pouvons-nous les modéliser ? Avons-nous l’explication de leurs variations dans le temps, en intensité et en position ? Quelques facteurs sont connus pour expliquer cette circulation thermohaline : la densité de l’eau liée à sa salinité et à sa température. Le mouvement se crée par aspiration des eaux atlantiques vers le nord. Toutefois, cette connaissance ne vaut, ni loi, ni théorie. En effet, outre la circulation thermohaline, interviennent d’autres facteurs dont la rotation terrestre, la circulation atmosphérique, la configuration des côtes.

L’hypothèse d’un Gulf Stream réchauffant les côtes européennes ouest a été faite en 1855 par Matthew Fontaine Maury, lieutenant de marine des États-Unis et auteur de The Physical Geography Of The Sea and its Meteorology. Sa thèse remporte un vif succès en montrant comment le Gulf Stream joue un rôle éminent, selon lui, dans la régulation des températures hivernales. Or, cette hypothèse, devenue abusivement une théorie, a été diffusée comme une vérité dans les manuels de géographie et les Encyclopédies. Pourtant, elle n’a jamais été démontrée. Le rôle climatique du courant marin est en fait mal apprécié. D’autres facteurs jouent un rôle plus important. L'énergie thermique accumulée au-dessus des mers chaudes pèserait plus, les courants océaniques (déviation des vents liée à la rotation de la Terre ou force de Coriolis) modifieraient plus le climat des côtes européennes, du fait de ces vents d’ouest dominants ; dont les mouvements sont eux-mêmes imprédictibles.

Les travaux de Richard Seager développent cette hypothèse. Ce climatologue de Columbia réhabilite la géographie et les facteurs d’altitudes : montagnes, plaines et les courants atmosphériques venant du Nord pour l’Amérique du Nord et du Sud-Ouest pour l’Europe occidentale. Dans ces modèles, la disparition du Gulf Stream aurait, selon lui, un impact de l’ordre de 4 à 6° en termes de refroidissement. Vous lisez bien : refroidissement. L’histoire du climat (paléoclimatologie) montre une corrélation entre les températures de l’hémisphère nord et les courants marins. Par le passé, des baisses significatives de 5 à 10° sont confirmées. Les spécialistes notent un tel refroidissement il y a moins de 10 000 ans. Et l’étude des sédiments marins, sans certitude, laisse supposer que des apports d’eau douce en Atlantique nord auraient ralenti le courant chaud. Et là encore, hypothèse, et non théorie, Martin Visbeck de l’Institut Leibniz des sciences de la mer à Kiel en Allemagne fait des calculs où ces courants perdraient 30% de leur force d'ici à la fin du siècle avec un effet de refroidissement.

Certains font un lien entre la fonte des glaces arctiques et leurs effets sur ce courant marin. Or, son affaiblissement aurait pour effet un refroidissement du climat en Europe occidentale ; celle-ci pouvant refroidir l’atmosphère et contribuer au retour des glaces arctiques restaurant alors le courant marin. Mais tout cela fait l’objet de modélisation parcellaire sans maîtrise globale du système. À ce stade, sauf à être dans la supercherie, personne ne sait prédire les variations d’une année sur l’autre des bras du Gulf Stream sur les côtes européennes et encore moins sur longue période, faute justement d’une connaissance de toutes les notions qui le décriraient, de leurs métriques et de leur composition dans une équation fiable dans ses prédictions à des horizons de temps observables. Et ses effets sont diversement appréciés. On est loin de la certitude.

L’activité solaire

Deuxième exemple : l’activité solaire. L’exposition journalière (nocturne-diurne) et annuelle (révolution terrestre-trajet autour du Soleil) conditionne les variations des températures journalières très significatives en amplitude et les phénomènes de saisons, selon les positions dans les hémisphères. Cette activité solaire est partiellement décrite, partiellement connue, très partiellement calculée. Il existe des formules dont celle de Wolf : R = k(t+10g) à partir de l’observation du nombre de taches solaires observées (non prédites) et du nombre de groupes de taches et d’un coefficient k en fonction des instruments d’observation et des observations, soit un degré d’aléas au passage.

Trois sources pour étayer, une de vulgarisation, deux institutionnelles :

L'activité du Soleil dépasse considérablement les prédictions des scientifiques - (Ça m'intéresse)

Météo de l’espace : quand l’activité solaire chamboule la Terre (INSU CNRS)

Quel est l’impact de l’activité solaire sur le climat ? (Institut Pierre-Simon Laplace)

Savons-nous comment fonctionne le soleil et avons-nous une théorie complète des cycles solaires ? Non. Le CNRS indique, par exemple, que nous ne savons pas prédire les éruptions solaires. Dans l’article en référence, Aurélie Marchaudon, directrice de recherche au CNRS (astrophysique et planétologie) explique :

« Le problème est que l’impact d’une EMC sur la Terre dépend énormément des paramètres de son champ magnétique et que nous ne savons pas mesurer la structure du champ magnétique dans une EMC à distance ».

L’activité solaire décrite par l’IPSL (Institut Pierre-Simon Laplace – Sciences du climat) donne lieu à un commentaire déjà édifiant pour justifier notre prudence :

« Or le Soleil a longtemps été un symbole d’immuabilité. À tel point que la puissance rayonnée dans tout le spectre (appelée irradiance totale) porte aujourd’hui encore le nom de constante solaire. Il aura fallu attendre le début de l’ère spatiale pour réaliser que cette constante varie. Toutefois, sa variation relative sur un cycle solaire de 11 ans ne dépasse guère 0.4 ‰, ce qui est bien trop faible pour rendre compte des variations de température observées sur Terre. Le débat fait aujourd’hui rage pour trouver des mécanismes physiques susceptibles d’amplifier de telles variations ».

Soyons clairs, même si les mesures progressent, la connaissance de l’irradiance totale est partielle parce que les types de rayonnements et leur absorption sont mal connus. Ces travaux posent des hypothèses sur la variabilité du cycle solaire. Or, ceux-ci sont basés sur des mesures par satellites (SORCE et TIMED) depuis seulement une dizaine d’années. Le recul est dérisoire à l’échelle de l’histoire des planètes. Ces chercheurs manipulent des pistes de recherche : rayonnement électromagnétique, champ magnétique, étude physico-chimique de la haute atmosphère, effet électrique de la magnétosphère terrestre, effet des vents solaires et d’autres pistes encore plus lointaines et discutées dont le rayonnement cosmique. L’INPS conclut à ce jour en disant :

« Tous ces mécanismes sont couplés, et il est fort difficile d’isoler leur contribution ».

C’est exactement ce que j’explique au début de cet article : modèle, facteurs, pondération, règles de combinaison arithmétique sont aujourd’hui totalement instables, parce que les sciences qui étudient des domaines essentiels sont chacune incapable de livrer un modèle stable et expérimentalement éprouvé. Les scientifiques les plus honnêtes en concluent la chose suivante, comme dans cette thèse de doctorat :

« Les observations continues ne couvrant que les trois derniers cycles solaires environ, 8 elles sont insuffisantes pour être utilisées dans les simulations climatiques à long terme ». (Cassandra Bolduc - Modélisation de l’irradiance solaire totale et spectrale et applications à la chimie stratosphérique terrestre – Thèse de doctorat de physique, Université de Montréal, 2014). La modélisation est donc sur ce point inaccessible. On est loin de la certitude.

Ces grands facteurs élémentaires indispensables à une théorie du climat ne font pas l’objet d’une modélisation éprouvée. Et les travaux scientifiques dans chacune de ces disciplines sont humbles, prudents, exposant des possibilités, testant des hypothèses, sans excès de prétention ou d’arrogance. Tout est très parcellaire et imparfait, dès ce premier niveau. Comment à un niveau secondaire qui agrège des savoirs instables, pourrions-nous miraculeusement être dans les certitudes ?

Question 3 : comment faire l’impasse sur le lointain passé ?

Prenons deux exemples : les glaciations et le carbone. Commençons par les glaciations.

Les glaciations

Les documents du GIEC se focalisent le plus souvent sur des périodes brèves, de l’ordre de quelques décennies, là où les climats jouent sur des millions d’années. Il est intéressant de revenir sur les facteurs explicatifs avancés pour décrire, par exemple, les ères glaciaires ?

1. Les glaciers connaissent des mouvements d’extensions et de contractions. Cette hypothèse est formulée en 1841 par Jean-Pierre Perraudin (1767-1858). Découverte ! Ils ne sont pas éternels.

2. Les alternances entre périodes glaciaires et interglaciaires, mais aussi le fait que des ères géologiques soient globalement froides ou chaudes, s’expliquent par la variation de l’orbite terrestre. Le mathématicien Milankovitch met en évidence des cycles orbitaux selon trois périodicités de 20 milles, 41 milles et 100 mille ans : excentricité autour du Soleil, variation de l’oblique de l’axe, précession des équinoxes. C’est un facteur majeur, au passage négligé dans les premiers travaux des climatologues.

3. L’évolution de la tectonique des plaques a des effets majeurs sur les climats. La formation de l’isthme du Panama conduisit à l’orientation du Gulf Stream, dont on connaît l’impact sur l’Europe. À partir des carottes de sédiments marins, nous savons que les glaces ont été très étendues, la Suisse étant recouverte de glaciers. Les températures étaient de 8 à 10° C inférieures à celles d’aujourd’hui.

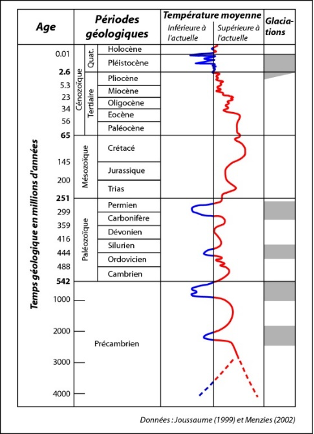

Plus encore, la terre a connu des périodes très chaudes et dépourvues totalement de glaciers, cas de l’ère mésozoïque (-251 à -65 millions d’années) (cf. document ci-après). Le lecteur observera de lui-même que l’essentiel des grandes périodes géologiques sont plus chaudes que le climat actuel. Alors soyons très prudents.

Sur des périodes plus récentes, nous avons vécu un petit âge glaciaire de 1350 à 1850 qui s’explique par une faible activité solaire cumulée au paramètre orbital de Milankovitch. Et un troisième facteur, totalement imprévisible, a joué un rôle : celui d’une fréquence d’éruptions volcaniques opacifiant l’atmosphère. Rappelons que l’intensité de l’activité volcanique est encore moins prédictible ! Ce cher Tazieff, vulcanologue célèbre, savait prédire une éruption, « le nez dessus », en analysant les émissions de gaz qui précèdent l’événement. Il n’a jamais prétendu prédire des événements volcaniques à des horizons de temps très lointain. Encore un critère très partiellement maîtrisé.

L’argument des fontes des glaces polaires de ces dernières années comme preuve du réchauffement climatique globale est alors très fragile. À l’échelle géologique, l’argument n’a pas de sens. Qu’en est-il vraiment ? Là encore, les mesures systématiques datent seulement de 1979. Et c’est avec ces quelques décennies à peine de recul qu’on prétend tirer des enseignements : moyennes, régressions, etc, ce qui sur le plan logico-mathématique relève évidemment de la pure mystification. Ce n’est pas avec quarante ans de mesure de phénomènes qui évoluent sur des millions d’années qu’on peut prétendre produire la moindre modélisation. Mais, puisque certains scientifiques utilisent très abusivement ces données, il faut rappeler que l’Antarctique augmente de 1% / décennie avec des variations fortes d’une année sur l’autre. D’ailleurs, certains considèrent, avec un peu d’honnêteté intellectuelle, que ce phénomène est un défi pour l’hypothèse du réchauffement général. Une troisième fois, on est loin des certitudes.

Le carbone

Qu’en est-il du carbone ? Le même procédé consiste à évoquer des chiffres sur une très courte période, sans modèle théorique pour en expliquer les facteurs, en se gardant bien d’indiquer ce qu’il en est à l’échelle de l’histoire de la planète. Il en est de même du carbone que de la température et du tableau précédent. En effet, la question du carbone n’est pas simple. Nous n’avons pas de mesure directe du taux de carbone dans l’atmosphère pour le passé. La mesure est indirecte, et elle passe par quelques hypothèses, donc elle évoluera au fur et à mesure des recherches scientifiques. Comme le précise Pierre Thomas, professeur à l’ENS-Lyon, il faut utiliser des informations à partir de matériau témoin. C’est par exemple l’indice stomatique des feuilles végétales. Il existe une corrélation inverse entre les stomates des feuilles des plantes vasculaires et la quantité de CO2. Les paléoclimatologues utilisent le Ginkgo biloba présent depuis le Permien (dernière époque géologique du Paléozoïque : -299 millions d'années à -251 millions d'années). Cet arbre est un rescapé des ères antérieures uniques. Ces fossiles permettent de compter les stomates et de reconstruire les quantités de CO2 atmosphérique sur des centaines de millions d’années.

Les variations sont très importantes. Le taux aurait été comparable à celui d’aujourd’hui au carbonifère puis aurait augmenté jusqu’au crétacé jusqu’à cinq fois la quantité actuelle. Pour les périodes antérieures, les scientifiques utilisent des bilans sédimentologiques. La mesure est plus incertaine. Abstraction faîtes des méthodes – indirectes, donc plus hypothétiques et spéculatives – les quantités auraient été des milliers de fois supérieures. Sur la période des derniers 600 millions d’années, les variations semblent être de 0,5 à 20 fois la quantité actuelle. Certains phénomènes sont très complexes et se jouent sur de longues périodes. Par exemple, la fossilisation de matière organique (lignine et charbon) fait diminuer le taux. De même, des phénomènes chimiques transfèrent le carbone de l’atmosphère dans les roches carbonatées. Quant au rôle des forêts, rappelons, par exemple, que l’ère glaciaire qui s’achève avec l’Holocène ne laisse pas de place aux forêts en Europe. C’est donc durant ces 12 000 dernières années que se sont constitués le milliard d’hectares de forêts européennes, soit environ un quart de l’espace forestier mondial actuel. On est loin d’une certitude et de normes, une quatrième fois.

Question 4 : des critiques sont-elles parfaitement entendables ?

La réalité est donc toute autre. Le rapport du GIEC de 2014 reconnaît à demi-mot l’immense difficulté qui rend toute simulation incomparable avec une prédiction théorique, à la façon de la chute des corps :

« Chaque parcelle de complexité ajoutée, bien que destinée à améliorer un aspect du climat simulé, introduit également de nouvelles sources d’erreurs possibles (par exemple, via des paramètres incertains) et de nouvelles interactions entre les composants du modèle qui peuvent, ne serait-ce que temporairement, dégrader la simulation par un modèle d’autres aspects du système climatique ».

Le GIEC se prémunit des critiques futures.

En effet, comment modéliser des variables sur quelques années pour évaluer leurs interactions et leurs pondérations dans une équation en prétendant rendre compte de phénomènes par extrapolation sur des décennies ou des siècles, sans aucun corpus théorique en la matière ? Soyons très clairs. Quel est le poids de l’activité solaire et de la révolution astronomique terrestre sur le climat ? Dans une théorie éprouvée, ceci devrait être parfaitement connu.

D’ailleurs, les controverses sont nombreuses et l’argument du consensus scientifique ramène la science à une démocratie d’opinion. Devons-nous rappeler l’épisode de l’unanimité de la communauté médicale européenne au 19e siècle contre le médecin Semmelweis concernant l’absence d’hygiène des mains, cause des fièvres puerpérales pour ne donner aucun crédit à l’unanimisme d’une communauté. Faut-il relire Feyerabend pour comprendre les intérêts bureaucratiques et moutonniers d’une communauté asservie à ses financements et à un conformisme social inquiétant pour l’avenir de l’esprit scientifique en Occident d’ailleurs ?

Sur le fond du dossier, la controverse est pourtant bien réelle. Reprenons quelques critiques majeures. Le lecteur me pardonnera un peu de complexité, mais dans certains cas, faire simple, c’est renoncer à la compréhension et s’exposer à la manipulation.

Première critique : ne jamais oublier que ces scientifiques travaillent dans des laboratoires dont les financements dépendent des politiques qui ont commandé des études dans le but de justifier leur politique sous la pression des idéologues écologistes issus de nombreux pays. En clair, les scientifiques ne sont pas libres. Le consensus en est d’ailleurs une manifestation troublante. N’oublions pas le mandat donné à l’institution du GIEC qui suffit à en discréditer la loyauté intellectuelle, du fait même de son obligation de ne pas trahir ce pour quoi l’institution a été mandatée. C’est donc un postulat !

« Le GIEC a pour mission d'évaluer, sans parti pris et de façon méthodique, claire et objective, les informations d'ordre scientifique, technique et socio-économique qui nous sont nécessaires pour mieux comprendre les fondements scientifiques des risques liés au changement climatique d'origine humaine, cerner plus précisément les conséquences possibles de ce changement et envisager d'éventuelles stratégies d'adaptation et d'atténuation » (Voir les principes régissant les travaux du GIEC).

Le changement climatique n’est plus une hypothèse, c’est le dogme dont l’institution est garante. Son mandat est de démontrer l’origine humaine, deuxième dogme, et le troisième, celui de l’action. Où est la liberté du chercheur qui viendrait contredire ces dogmes ? Nous ne sommes plus dans la science, mais dans une politique scientifique ! La chose est tellement vraie que le dernier rapport brasse des milliers de données sans rien démontrer. Tout est réputé acquis dans un gigantesque truisme. C’est un rapport technocratique, certainement pas une production théorique ou scientifique digne de ce nom.

Je consacrerai un prochain article à ce dernier rapport édifiant.

Deuxième critique : ne pas confondre la simulation informatique et la connaissance théorique résultant d’une épreuve véritable entre des équations et des résultats avec l’exactitude requise. Keery Emanuel, spécialiste mondialement reconnu des ouragans, s’interroge sur la confusion entre brassage des données et réflexion théorique. Il en fut de même en économie pendant une période où la fascination des modélisations mathématiques fit s’égarer les économistes dans des calculs et des représentations abstraites inconséquentes, sans preuves expérimentales, désarticulées des faits et des mesures. Le dernier rapport du GIEC est emblématique tant il regorge de résultats quantitatifs à plat, sans jamais faire une quelconque démonstration digne de ce nom.

Troisième critique : les incertitudes sont légion à tous les niveaux. Citons, par exemple, outre l’activité solaire, les courants marins, la tectonique des plaques et les mouvements telluriques, la nature chaotique de la circulation atmosphérique. Et les incertitudes s’expriment dans les résultats des calculs. En effet, les prévisions sont simplement irrecevables tant elles sont imprécises. On en est à la météo avec des écarts considérables. Ce n’est pas de la prédiction étayée, c’est de la statistique avec de l’aléatoire, des hypothèses, des scénarios et une multitude de choix, de biais. Avec des modélisations prétendument informatisées à l'extrême, les marges d’erreurs sont considérables. Il suffit d’examiner l’état de la recherche et ses incertitudes théoriques dans chacun des compartiments pour s’inquiéter de la robustesse des spéculations du GIEC.

En fait, le raisonnement du GIEC se résume aujourd’hui à cette formule :

« Aujourd’hui, les causes sont identifiées ; ce sont les émissions liées aux activités humaines, dont l’ampleur rend difficile tout espoir d’inverser la tendance à moins d’un sursaut général et mondial. Contrairement aux émissions de particules fines par exemple, la pollution liée au CO2 est globale et entraîne le réchauffement ».

Nous verrons dans un second article ce qu’il en est de cette affirmation. Il y a de quoi douter.

Essayiste, chercheur et fondateur de l'Institut de Recherches de Philosophie Contemporaine, Pierre-Antoine Pontoizeau a notamment publié des ouvrages sur la théorie de la communication, la théorie des organisations, la théorie du langage politique et la philosophie des mathématiques.

- Source : FranceSoir